Avatar-basierte Gebärdensprachübersetzung

Umgesetzt wurde der Gebärdensprach-Avatar für Kommunen und Unternehmen auf Basis vom Forschungsprojekt AVASAG (Avatar-basierter Sprachassistent zur automatisierten Gebärdenübersetzung) für den Datenbereich "Reise". Für die Weiterentwicklung erfolgt eine Erweiterung der Inhalte im Korpusdatenbereich beziehungsweise Vokabular über den Reisekontext hinaus hin zur behördlichen und unternehmerischen Kommunikation.

Im folgenden Video wird das Forschungsprojekt AVASAG vorgestellt, das sich mit der automatisierten Übersetzung von gesprochenem oder geschriebenem Text in Gebärdensprache durch Einsatz eines Avatars beschäftigt. Der virtuelle Avatar dient als gebärdende Figur und ermöglicht gehörlosen oder hörgeschädigten Menschen den Zugang zu Inhalten, die sonst in gesprochener Sprache vorliegen.

Digitale Kommunikation unterliegt einem schnelllebigen Wandel, nimmt aber nicht alle Menschen mit. Weltweit leben ca. 70 Millionen Gehörlose, für die meisten ist Textsprache wie eine Fremdsprache. Digitale Barrierefreiheit wird daher immer wichtiger, um Inhalte dynamisch und für alle Zielgruppen richtig aufbereitet zu kommunizieren. Entwicklungen in der Mensch-Technik-Interaktion unterstützen bei einer barrierefreien Kommunikation. Barrierefreie digitale Inhalte sind notwendig, damit alle Menschen die heutigen technischen Möglichkeiten nutzen können und so eine umfassende digitale Teilhabe erfüllt werden kann. Öffentlichen Stellen und Unternehmen soll die Erfüllung gesetzlicher Verpflichtungen ermöglicht werden.

In dem vom Bundesministerium für Bildung und Forschung (BMBF) geförderten Verbundprojekt AVASAG (Avatar-basierter Sprachassistent für automatisierte Gebärdenübersetzung) entwickeln sechs Partner aus Forschung und Entwicklung ein neuartiges Echtzeit-Gebärdenanimationsverfahren für 3D-Avatare. Durch die Kombination von maschinellen Lernverfahren mit regelbasierten Syntheseverfahren werden Texte in Gebärden abgebildet. Dies geschieht unter präziser Auflösung der zeitlichen und räumlichen Abhängigkeiten der Zeichenelemente für qualitativ hochwertige Ergebnisse:

- Eingabetext (z. B. in deutscher Sprache) wird in eine strukturelle Repräsentation überführt, die dann in Gebärdensprache umgesetzt wird.

- Der Avatar zeigt dabei typische Gebärden- und Körper- bzw. Mimikbewegungen, die für die Verständlichkeit in Gebärdensprache essenziell sind.

- Bei Gebärdensprache zählen nicht nur die Hände, sondern auch Gesichtsausdruck, Körperhaltung und räumliche Elemente spielen eine große Rolle.

Ein Ziel des Projekts ist es, Übersetzungen möglichst flüssig und natürlich wirken zu lassen, also nicht starr oder roboterhaft, damit Menschen, die Gebärdensprache nutzen, die Darstellung gut nachvollziehen können.

Technisch komplex ist beispielsweise die Erfassung nützlicher Daten, die Nutzung neuester Technologien zur Erkennung von Mimik und Bewegung, die Aufbereitung der Trainingsdaten für maschinelles Lernen und Künstliche Intelligenz, die Datengenerierung in Echtzeit, aber auch die Animation des Avatars unter Berücksichtigung diverser Merkmale wie Ausprägung, Emotionalität, Synchronität und Genauigkeit.

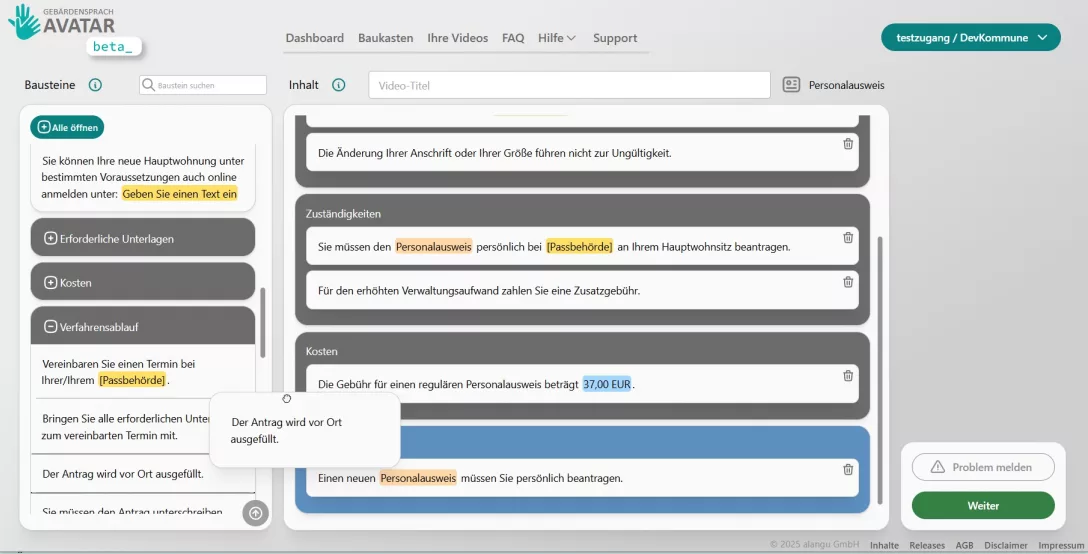

Mögliche Anwendungsszenarien für Web, Kiosk und Mobile sind zum Beispiel Webseiten, Behörden, Bildungsbereiche und jegliche Videos beziehungsweise überall dort, wo Inhalte barrierefrei in Gebärdensprache verfügbar gemacht werden sollen.

Für Updates zu unseren neuesten Entwicklungen:

Auch interessant:

Wie entsteht ein Gebärdensprach-Video?

Wie funktioniert die Qualitätssicherung bei alangu?

Wie bringen wir unserer KI Gebärdensprache bei?